单例模式概念

今天给大家讲讲单例模式演变流程,从C++98到C++11经历了哪些变化?哪一种单例模式更为安全。

单例模式(Singleton Pattern)是一种创建型设计模式,旨在确保一个类在整个应用程序生命周期中仅且只有一个实例,并提供一个全局访问点以获取该实例。设计单例模式的主要原因和作用包括以下几个方面:

1. 控制实例数量

单例模式确保一个类只有一个实例,防止在程序中创建多个实例可能导致的资源浪费或状态不一致问题。例如,数据库连接池、配置管理类等通常使用单例模式,以确保全局只有一个连接池或配置实例。

2. 提供全局访问点

单例模式通过提供一个全局访问点,使得在程序的任何地方都可以方便地访问该实例。这对于那些需要在多个模块或组件之间共享的资源或服务尤为重要,如日志记录器、缓存管理器等。

3. 延迟实例化

单例模式通常采用懒加载的方式,即在第一次需要使用实例时才创建。这有助于节省系统资源,特别是在实例创建成本较高或初期并不需要该实例的情况下。

4. 避免命名冲突

通过将单例实例作为一个类的静态成员,可以避免在全局命名空间中引入多个实例,减少命名冲突的风险。

5. 管理共享资源

在多线程环境下,单例模式可以有效管理共享资源,确保线程安全。例如,操作系统中的线程池、任务管理器等常使用单例模式,以协调多个线程对资源的访问。

设计单例模式的考虑因素

虽然单例模式有诸多优点,但在设计和使用时也需要注意以下几点:

- 线程安全:在多线程环境下,需要确保单例实例的创建和访问是线程安全的,常用的方法有双重检查锁定(Double-Checked Locking)和使用静态内部类等。

- 延迟初始化:根据需求选择是否采用延迟初始化,以平衡性能和资源利用。

- 可测试性:单例模式可能会影响代码的可测试性,特别是在单元测试中,可能需要通过依赖注入等手段来替代单例实例。

- 限制扩展:单例模式通过限制实例数量可能会限制类的扩展性,需谨慎使用。

适用场景

- 需要确保全局只有一个实例的场景,如配置管理、日志系统、设备驱动等。

- 需要全局访问点来协调系统中的多个部分,如缓存、线程池等。

不适用场景

- 需要多个实例以满足不同需求的场景。

- 对象的生命周期需要更灵活控制的场合。

总的来说,单例模式通过控制类的实例数量和提供全局访问点,为系统资源管理和状态一致性提供了有效的解决方案。然而,在实际应用中,应根据具体需求和上下文环境,谨慎决定是否使用单例模式,以避免潜在的设计问题。

局部静态变量方式

这种方式最简单

1 | //通过静态成员变量实现单例 |

上述代码通过局部静态成员single实现单例类,原理就是函数的局部静态变量生命周期随着进程结束而结束。上述代码通过懒汉式的方式实现。

调用如下

1 | void test_single2() |

程序输出如下

1 | sp1 is 0x1304b10 |

确实生成了唯一实例,在C++98年代,上述单例模式存在隐患,对于多线程方式生成的实例可能时多个。

随着C++ 11的来临,这种方式不再存在线程安全问题,是最为简单也是最适合新手的方式。

静态成员变量指针方式(饿汉式)

可以定义一个类的静态成员变量,用来控制实现单例,这种方式依靠静态成员提前初始化保证生成的单例是唯一的。

1 | //饿汉式 |

这么做的一个好处是我们可以通过饿汉式的方式避免线程安全问题

1 | //饿汉式初始化 |

程序输出如下

1 | s1 addr is 0x1e4b00 |

可见无论单线程还是多线程模式下,通过静态成员变量的指针实现的单例类都是唯一的。

饿汉式是在程序启动时就进行单例的初始化,这种方式也可以通过懒汉式调用,无论饿汉式还是懒汉式都存在一个问题,就是什么时候释放内存?

多线程情况下,释放内存就很难了,还有二次释放内存的风险。

静态成员变量指针方式(懒汉式)

我们定义一个单例类并用懒汉式方式调用

1 | //懒汉式指针 |

在cpp文件里初始化静态成员,并定义一个测试函数

1 | //懒汉式 |

函数输出如下

1 | this is lazy thread 0 |

此时生成的单例对象的内存空间还没回收,这是个问题,另外如果多线程情况下多次delete也会造成崩溃。

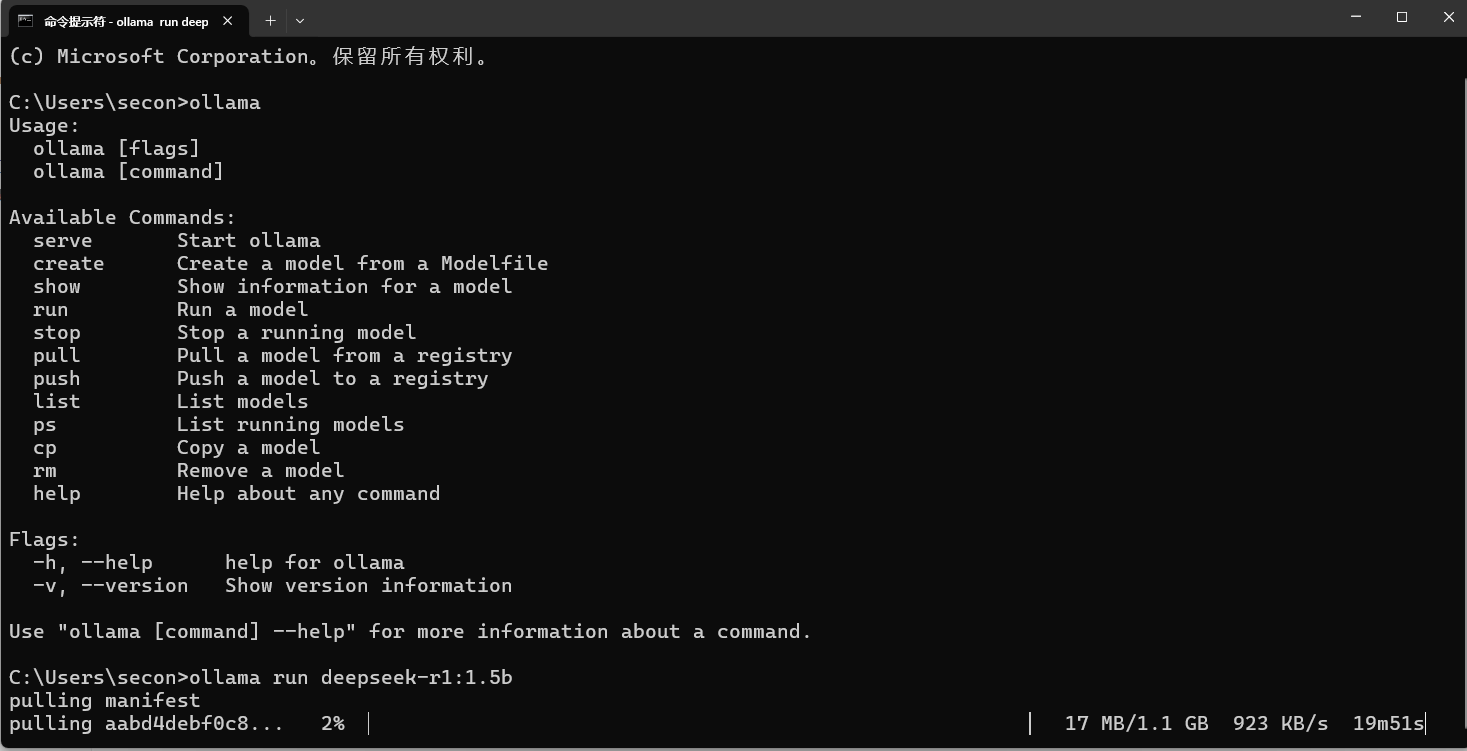

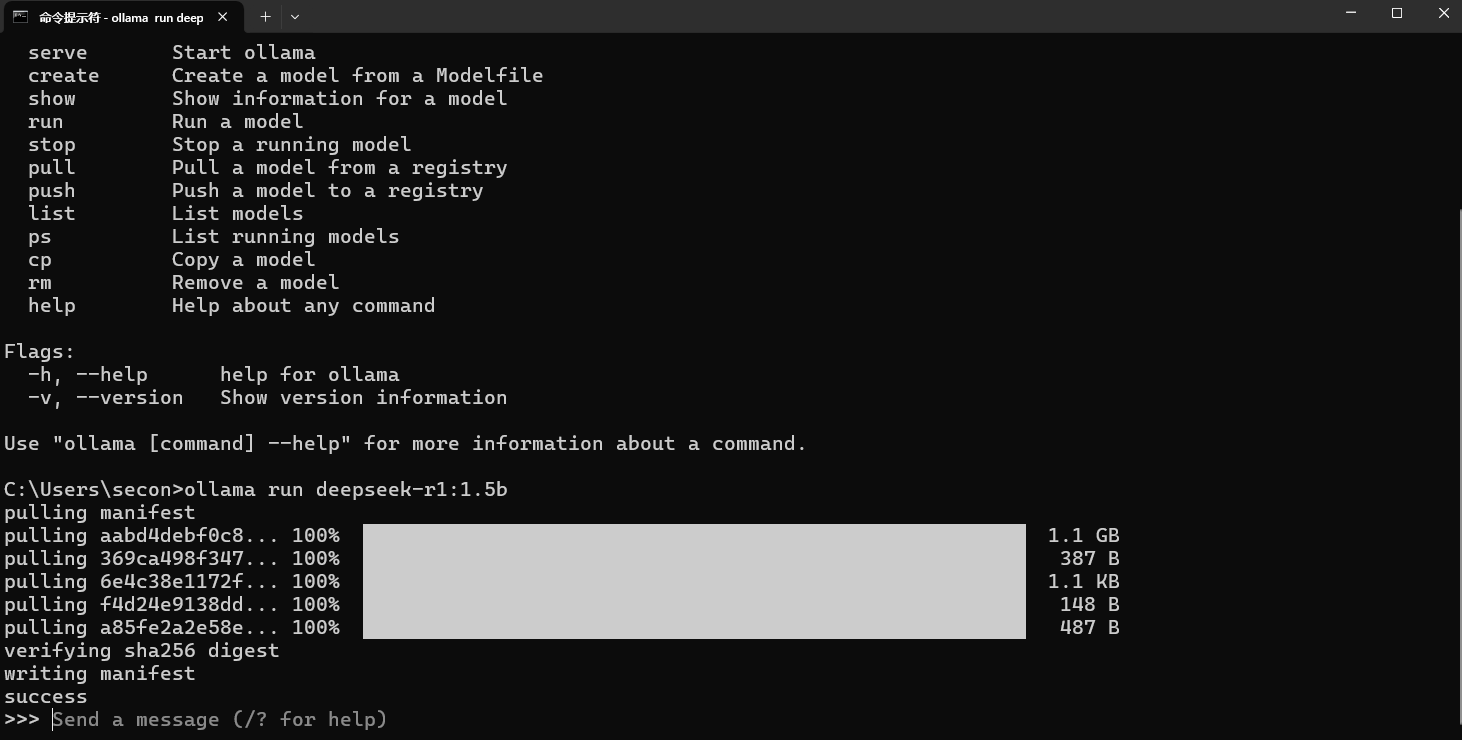

C++11改进

我们可以利用C++11 提供的once_flag实现安全的创建

1 |

|

static成员要在cpp中初始化

1 | SingletonOnceFlag *SingletonOnceFlag::_instance = nullptr; |

测试

1 |

|

测试结果

1 | 0x19a74de7420 |

智能指针方式(懒汉式)

可以利用智能指针自动回收内存的机制设计单例类

1 |

|

同样在SingletonOnceFlag.cpp中进行单例成员的初始化

1 |

|

再次测试

1 |

|

这次输出析构信息

1 | 0x1d620a47420 |

辅助类智能指针单例模式

智能指针在构造的时候可以指定删除器,所以可以传递一个辅助类或者辅助函数帮助智能指针回收内存时调用我们指定的析构函数。

1 | // |

在cpp文件中实现静态成员的定义

1 |

|

SafeDeletor要写在SingleAutoSafe上边,并且SafeDeletor要声明为SingleAutoSafe类的友元类,这样就可以访问SingleAutoSafe的析构函数了。

我们在构造single时制定了SafeDeletor(),single在回收时,会调用SingleAutoSafe的仿函数,从而完成内存的销毁。

并且SingleAutoSafe的析构函数为私有的无法被外界手动调用了。

测试

1 |

|

程序输出

1 | 0x1b379b07420 |

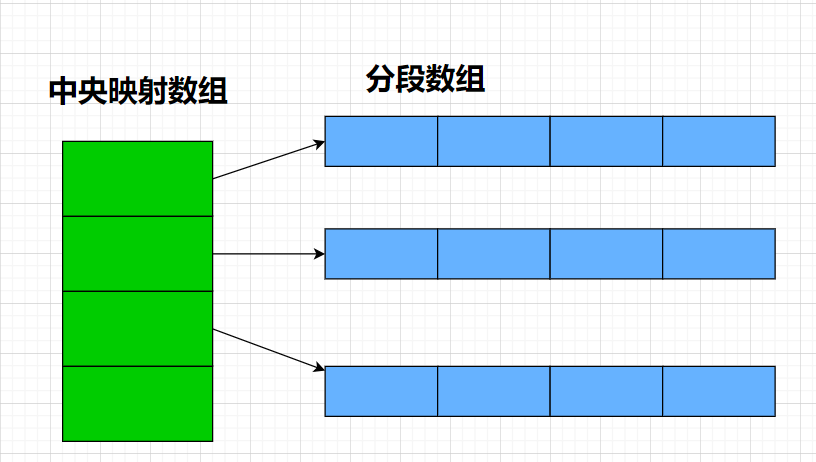

通用的单例模板类(CRTP)

我们可以通过声明单例的模板类,然后继承这个单例模板类的所有类就是单例类了。达到泛型编程提高效率的目的。

CRTP的概念

CRTP是一种将派生类作为模板参数传递给基类的技术,即一个类继承自一个以自身为模板参数的基类。这种模式常用于实现静态多态、接口的默认实现、编译时策略选择等。

比如

1 | template <typename T> |

单例基类实现

1 |

|

我们定义一个网络的单例类,继承上述模板类即可,并将构造和析构设置为私有,同时设置友元保证自己的析构和构造可以被友元类调用.

1 | //通过继承方式实现网络模块单例 |

测试案例

1 |

|

程序输出

1 | 0x212248b7420 |